-

Lösung:

-

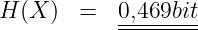

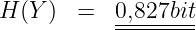

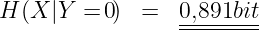

Die Lösung wird in der Vorlesung erarbeitet. Zahlenwerte sind:

- Entropie der Quelle X

- Entropie der Quelle Y

- Unsicherheit über X wenn Y = 0 empfangen wurde

- Unsicherheit über X wenn Y = 1 empfangen wurde

- Äquivokation oder Rückschlussentropie

-

Begriffe:

-

der Informationstheorie nach Shannon:

-

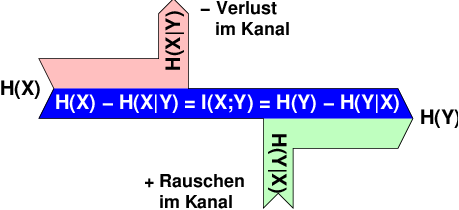

Äquivokation:

-

H(X|Y ) →− Verluste im Kanal

auch Verlustentropie genannt, ist die Information, die bei der

Übertragung über einen Kanal verloren geht.

-

Irrelevanz:

-

H(Y |X) → + Rauschen im Kanal

auch Fehlinformation genannt, ist die Information, die im Kanal selbst

erzeugt wird und somit minimal sein soll.

-

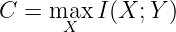

Transinformation:

-

I(X; Y ) → = Nutzen des Kanals

oder gegenseitige Information gibt die Stärke des statistischen

Zusammenhangs zweier Zufallsgrößen an. Die auch Synentropie eines

Kanals genannte Größe stellt den mittleren Informationsgehalt dar, der

vom Sender zum Empfänger gelangt und somit maximal sein

soll.

-

Diagramm:

-

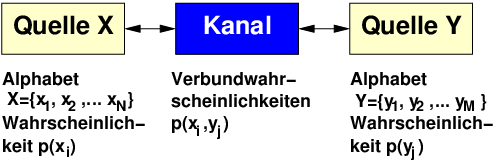

Im Informationsflussdiagramm in Abb. 6.3.2 wird die Veränderung der

zu übertragenden Nachricht mit Hilfe dieser Entropien

-

Entropie:

-

Die bisher nicht verwendete Irrelevanz oder Streuentropie

H(Y |X) enthält die Ungewissheit der empfangenen Zeichen bei

bekanntem Sendezeichen. Kanalstörungen wirken wie störende

Informationsquellen!

-

Kanal:

-

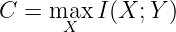

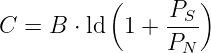

Die Kanalkapazität ist das Maximum der Transinformation eines

vorgegebenen Kanals. Sie ist unabhängig von einer tatsächlichen Quelle

X.

| (6.3.1) |