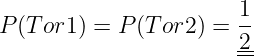

Die Lösung wird in der Vorlesung erarbeitet. Zahlenwerte sind:

- Gewinnchance

- —

- Gewinnchancen

Die Wahrscheinlichkeitslehre bildet die Grundlage der modernen Nachrichtentechnik

→Übertragungstechnik und Vermittlungstechnik.

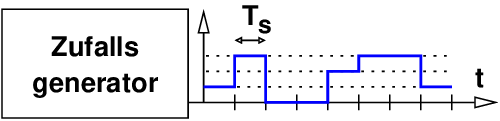

Ein idealer Zufallsgenerator erzeuge an seinem Ausgang ein vierstufiges Zufallssignal wie Abb. 6.1.1 dargestellt .

Ein Experiment liefert genau einen Wert, das Ereignis x ∈ H aus der Menge aller möglichen Ereignisse H = {0, 1, 2, 3}. In einer Beobachtungszeit TB treten die Ereignisse xk ∈ E auf aus dem Ereignisfeld, der Menge der eingetretenen Ereignisse E ∈ H des Experiments.

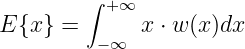

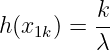

Betrachtet man nicht die Folge der Ereignisse xk(t), sondern fragt nach der relativen Häufigkeit, mit der ein bestimmtes Ereignis aufgetreten ist, so erhält man

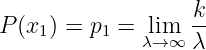

| (6.1.1) |

wenn das Ereignis x1k = 1 genau k-mal von insgesamt λ Ereignissen aufgetreten ist.

Bildet man den Grenzwert für λ →∞ so erhält man die statistische Wahrscheinlichkeit zu

| (6.1.2) |

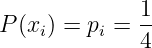

Die 4 möglichen Ereignisse x0, x1, x2 und x3 bei einem idealen Zufallgenerator sind alle gleich wahrscheinlich

| (6.1.3) |

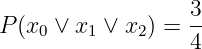

Die Wahrscheinlichkeit, dass entweder x0 ODER x1 ODER x2 eintritt, ist dann

| (6.1.4) |

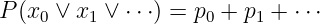

Daraus lässt sich das Additionsgesetz der Wahrscheinlichkeiten für unabhängige Zufallsereignisse herleiten

| (6.1.5) |

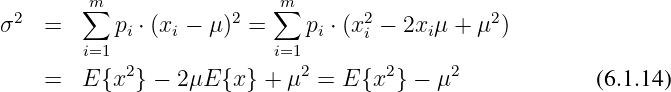

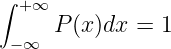

Die Summe der Wahrscheinlichkeiten von Ereignissen in einem vollständigen System ist immer

| (6.1.6) |

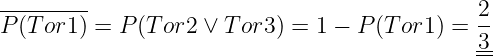

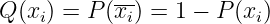

Tritt bei einem Experiment das Ereignis xi mit der Wahrscheinklichkeit p(xi) auf, so tritt es nicht auf mit der Wahrscheinlichkeit

| (6.1.7) |

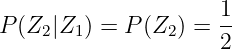

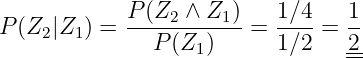

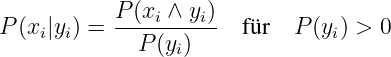

Die bedingte Wahrscheinlichkeit beschreibt das Ereignis xi unter der Bedingung, dass vorher das Ereignis yi sicher eingetreten ist

| (6.1.8) |

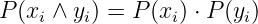

Sind aber die Ereignisse xi und yi statistisch unahhängige Ereignisse, so folgt mit

| (6.1.9) |

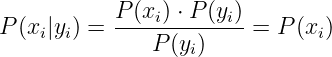

direkt wieder

| (6.1.10) |

Daraus lässt sich das Multiplikationsgesetz der Wahrscheinlichkeiten für unabhängige Zufallsereignisse herleiten

| (6.1.11) |